الذكاء الاصطناعي أصبح زميلك في العمل.. هل يمكنك الوثوق به؟

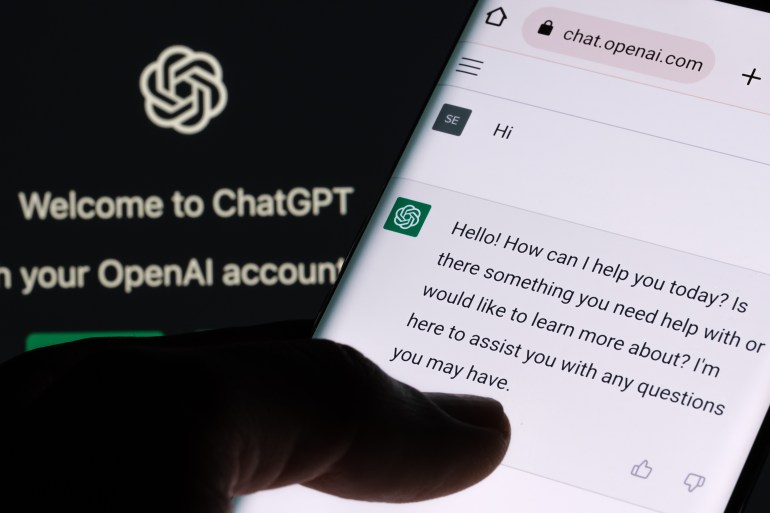

أصبح استخدام أدوات الذكاء الاصطناعي، مثل شات جي بي تي (ChatGPT) من شركة “أوبن إيه آي” (OpenAI) وكوبايلوت (Copilot) من مايكروسوفت (Microsoft)، جزءًا لا يتجزأ من الروتين اليومي في الأعمال.

ومع تسارع تطور هذه الأدوات، تتزايد المخاوف بشأن تأثيرها على الخصوصية والأمان، خاصة في بيئات العمل. بينما يحث قادة الأعمال على دمج الذكاء الاصطناعي في استراتيجياتهم، يصبح من الضروري خلق الثقة وفهم كيفية تفاعل هذه التكنولوجيا مع الموظفين لضمان تحقيق أقصى استفادة من إمكانياتها.

خصوصية الموظفين… القلق من المراقبة

في مايو الماضي، أطلق نشطاء مؤيدون لحماية الخصوصية على أداة “ريكول” (Recall) من مايكروسوفت لقب “كابوس الخصوصية” بسبب قدرتها على أخذ لقطات شاشة للحاسوب بانتظام. وقد أثار هذا الأمر قلق هيئة تنظيم المعلومات في المملكة المتحدة التي طالبت بمزيد من الشفافية حول أمان المنتج المقبل.

وفي الوقت نفسه، تتصاعد المخاوف حيال “شات جي بي تي” أيضًا، والذي أظهر ميزات مشابهة في تطبيقه الجديد لنظام “ماك أو إس” (macOS)، مما قد يؤدي إلى جمع بيانات حساسة.

مجلس النواب الأمريكي حظر استخدام كوبايلوت بين موظفيه، مشيراً إلى أن مكتب الأمن السيبراني يعتبره تهديدًا محتملًا لتسريب البيانات إلى خدمات سحابية غير معتمدة.

على صعيد متصل، حذرت شركة غارتنر لتحليل السوق من المخاطر المرتبطة بكوبايلوت في “مايكروسوفت أوفيس 365” في مجال تسريب البيانات والمحتوى الحساس. كما اضطرت غوغل لتعديل ميزتها الجديدة “إيه آي أوفرفيوز” (AI Overviews) بعد انكشاف لقطات شاشة تتضمن إجابات مضللة.

يواجه مستخدمو الذكاء الاصطناعي التوليدي في بيئات العمل تحديًا حقيقيًا يتمثل في احتمالية كشف البيانات الحساسة عن غير قصد.

يقول كامدن وولفن، رئيس مجموعة الذكاء الاصطناعي في شركة إدارة المخاطر “جي آر سي إنترناشونال غروب”، إن معظم أنظمة الذكاء الاصطناعي هي في الأساس “إسفنجات كبيرة” تمتص كميات هائلة من المعلومات من الإنترنت لتدريب نماذجها.

تثير أدوات الذكاء الاصطناعي القلق بسبب احتمال استخدامها لمراقبة الموظفين، مما ينتهك خصوصيتهم. تشير ميزة “ريكول” من مايكروسوفت إلى أن “لقطاتك الخاصة تبقى محصورة في حاسوبك” و”أنت دائمًا تتحكم في الخصوصية التي يمكنك الوثوق بها”.

ومع ذلك، يحذر ستيف إلكوك، الرئيس التنفيذي لشركة إليمنت سويت للبرمجيات، من أن استخدام هذه التكنولوجيا لمراقبة الموظفين قد يصبح قريبًا واقعًا.

الثقة أساس العمل الحديث

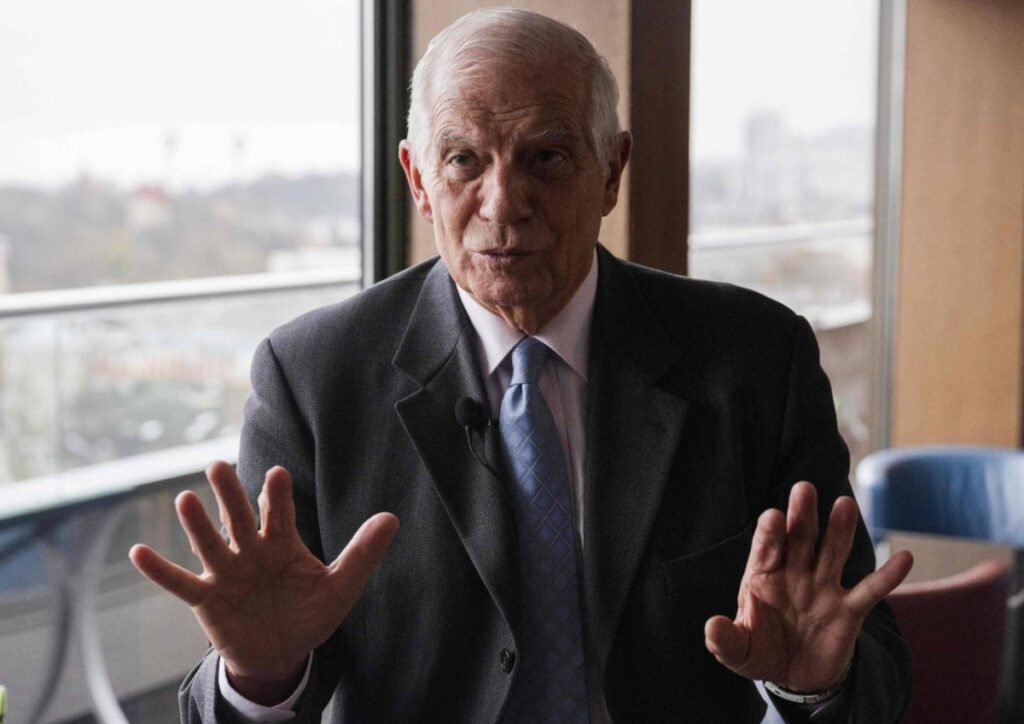

يؤكد مايكل بوش، الرئيس التنفيذي لشركة “غريت بليس تو وورك”، على الدور الحيوي للذكاء الاصطناعي في تعزيز الاتصال بين الموظفين والمنظمات. ويقول إن الثقة تتجاوز كونها مفهومًا مجردًا، فهي عامل أساسي في خلق بيئة يشعر فيها الجميع بالتقدير والاستماع.

يضيف بوش: “إذا كان بإمكاني أن أضع وصفة للنجاح في هذا الوقت، ستكون الثقة في جوهرها. يجب أن يمتد شعور الثقة هذا إلى بناء موثوقية في أنظمة الذكاء الاصطناعي”.

عندما يثق الموظفون في نوايا تكنولوجيا الذكاء الاصطناعي، يصبحون أكثر استعدادًا لتقبلها والتعاون معها. يوفر ذلك بيئة أكثر أمانًا حيث يرغبون في معرفة المزيد بدلاً من الخوف من فقدان وظائفهم.

اعتبارات رئيسية للحفاظ على خصوصية الموظفين

على الرغم من انتشار تقنيات الذكاء الاصطناعي في أماكن العمل، تثير هذه التقنيات مخاوف بشأن الخصوصية عند مشاركة المعلومات الحساسة. من الأساسي حماية هذه المعلومات، حيث تعتمد الأنظمة على البيانات التي تتلقاها.

تدابير أمن البيانات

تعتبر تدابير أمن البيانات جوانب أساسية عند تنفيذ الذكاء الاصطناعي في أماكن العمل. يجب على أصحاب العمل ضمان وجود تدابير أمان قوية لحماية معلومات الموظفين، خاصة البيانات الحساسة، مثل التشفير وضوابط الوصول.

الشفافية

الشفافية عنصر أساسي في معالجة المخاوف المتعلقة بالذكاء الاصطناعي، يجب أن يكون أصحاب العمل منفتحين بشأن كيفية استخدام هذه التقنية والبيانات التي يتم جمعها. يسهم التواصل الشفاف في تعزيز الثقة وفهم غايات استخدام الذكاء الاصطناعي، مما يقلل من القلق بشأن الخصوصية.

الحد من البيانات

للتقليل من مخاطر الخصوصية، يجب أن يلتزم أصحاب العمل بمبدأ الحد من جمع البيانات، حيث يقتصر الجمع على ما هو ضروري فقط لأداء مهام الذكاء الاصطناعي.

تجنب تجميع بيانات إضافية لا ترتبط بالغرض الجوهري للذكاء الاصطناعي يساهم في تقليل الانتهاكات المحتملة للخصوصية.

التدريب والإرشادات

لضمان استخدام الموظفين أنظمة الذكاء الاصطناعي بأمان، يجب تزويدهم بالتدريب المناسب وإيضاح الإرشادات اللازمة للاستخدام الفعال. يتضمن ذلك تثقيفهم بأفضل الممارسات في إدخال البيانات والتعامل معها.

إخفاء هوية البيانات

إضافة إلى حماية الخصوصية، يوفر إخفاء هوية بيانات الموظفين طبقة أمان إضافية. يتضمن ذلك إزالة المعلومات القابلة للتحديد من بيانات الذكاء الاصطناعي، مما يجعل من غير الممكن التعرف على هوية الأفراد.

التعريف المستعار

يمكن لتقنية التعريف المستعار أو تشفير هوية البيانات أن تساهم في ضمان خصوصية الأفراد من خلال استبدال المعلومات القابلة للتحديد بأسماء مستعارة، ما يجعل البيانات لا تزال مفيدة للذكاء الاصطناعي دون التعرض لخصوصيات الأفراد.

تقييمات تأثير الخصوصية المنتظمة

يجب على أصحاب العمل القيام بتقييمات دورية لتأثير الخصوصية من أجل تحديد وتحليل المخاطر المرتبطة بأنظمة الذكاء الاصطناعي والتأكد من التزامها بمبادئ الخصوصية وحماية البيانات.

رابط المصدر